算法偏见检测工具推荐:识别与纠正不公平的利器

在当今数字化时代,算法已深度融入社会生活的方方面面,广泛应用于金融、医疗、招聘、司法等诸多领域。算法并非总是公正无私,算法偏见问题日益凸显,它可能导致不公平的决策,对个人权益和社会公平造成损害。因此,开发有效的算法偏见检测工具成为当务之急,这些工具犹如识别与纠正不公平的利器,能够帮助我们更好地审视算法背后的逻辑,发现潜在的偏见,并采取措施加以纠正。

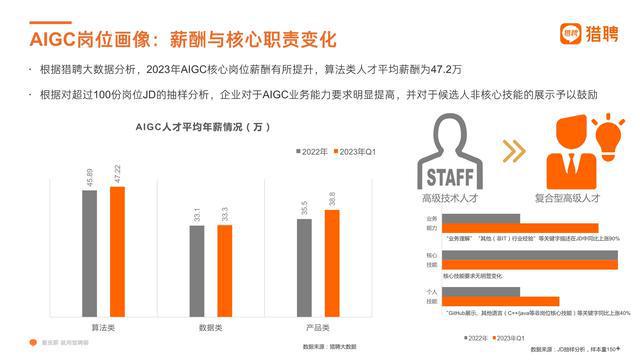

算法偏见的产生有着复杂的原因。一方面,训练数据存在偏差是一个重要因素。如果用于训练算法的数据本身就不具有代表性或存在错误信息,那么基于这些数据训练出来的算法必然会继承这种偏差。例如,在某些招聘算法中,若历史招聘数据中存在对特定性别或种族的隐性偏好,算法就可能在筛选简历和推荐候选人时产生不公平的偏向。另一方面,算法设计过程中的缺陷也可能导致偏见。算法开发者的主观认知、价值观以及技术能力等都可能影响算法的设计,使得算法在处理数据和做出决策时出现不合理的倾向。

面对算法偏见问题,各类算法偏见检测工具应运而生。其中一类工具侧重于数据层面的检测。它们能够深入分析算法所使用的数据,检查数据的完整性、准确性以及代表性。通过对数据的特征提取和统计分析,这类工具可以发现数据中存在的不均衡分布或异常值,从而揭示可能导致算法偏见的潜在因素。例如,一些专门的数据审计工具会对医疗数据中的种族、性别等因素进行分析,查看是否存在某些群体在疾病诊断、治疗方案推荐等方面受到不公平对待的情况。

还有一些算法偏见检测工具聚焦于算法模型本身的分析。它们通过模拟算法的运行过程,评估算法在不同输入情况下的决策结果,检测是否存在不公平的差异。这些工具可以采用多种技术手段,如对比不同群体在相同条件下的输出结果、分析算法的决策边界等,来判断算法是否存在对特定群体的歧视性倾向。比如,在信贷审批算法的检测中,这类工具可以发现算法是否对某些地区或职业的申请人给予不合理的高拒贷率。

还有一些综合性的算法偏见检测平台,它们结合了数据检测和模型分析等多种功能,能够提供全面、深入的检测报告。这些平台通常具备可视化界面,方便用户直观地了解算法偏见的表现形式和影响程度。它们还会给出相应的改进建议,帮助开发者优化算法,消除偏见。

算法偏见检测工具不仅能够识别算法中的偏见,更重要的是能够为纠正不公平提供有力支持。一旦发现算法存在偏见,这些工具可以协助开发者追溯问题根源,指导他们对数据进行清洗、扩充或调整算法模型结构。通过持续监测和改进,算法可以逐渐变得更加公平公正,确保在各个领域的应用中不会因偏见而导致不公正的结果。

算法偏见检测工具的发展仍面临一些挑战。检测技术的准确性和可靠性有待进一步提高。由于算法偏见的表现形式复杂多样,现有的检测工具可能无法完全准确地识别所有类型的偏见。如何平衡检测的效率和成本也是一个问题。过于复杂或耗时的检测方法可能会影响工具的实用性,而简单的方法又可能无法满足全面检测的需求。算法偏见检测工具的普及和应用还需要加强,许多开发者和相关机构对其重要性认识不足,缺乏使用这些工具的意识和动力。

为了更好地发挥算法偏见检测工具的作用,推动算法公平发展,我们需要多方面的努力。科研机构应加大对算法偏见检测技术的研究力度,不断探索新的方法和模型,提高检测的准确性和效率。行业组织和监管机构应制定相关标准和规范,要求在关键领域应用算法时必须进行偏见检测,并对检测结果负责。还需要加强对算法开发者和使用者的培训,提高他们对算法偏见问题的认识和应对能力。

算法偏见检测工具是识别与纠正不公平的重要利器。在数字化浪潮中,我们必须充分认识到算法偏见的危害,积极利用这些工具来保障社会公平正义。随着技术的不断进步和完善,算法偏见检测工具将在构建更加公平、公正的数字社会中发挥越来越重要的作用。只有通过持续的努力和创新,我们才能确保算法真正成为服务人类、促进社会发展的有益力量,而不是制造不公平的帮凶。让我们借助算法偏见检测工具的力量,为每一个人创造一个更加平等、公正的未来。